Model Context Protocol(MCP)终极指南

原创你是否遇到过这样的困境?

你是否遇到过这样的问题:明明在一次请求中设置好了模型上下文(如用户偏好、会话状态),但下一次调用时模型仿佛“失忆”,无法记住任何先前的设定?你调试良久,却不知道上下文是如何传递、持久或丢失的?这时你可能需要 Model Context Protocol(MCP) ——一种规范化管理上下文信息的结构化方式。

本文将带你通过三个步骤掌握 MCP 的基本原理与用法,让你的 AI 应用拥有“持久的记忆”。

步骤一:理解什么是 Model Context Protocol(MCP)

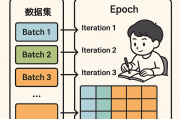

MCP 是一种为大型语言模型设计的上下文管理协议,用于持久化和动态更新模型使用时的上下文信息,如用户身份、偏好、对话目标等。

MCP 用于于协调 LLM 在与用户、数据库、搜索系统、插件等多个组件之间的数据流转。它的设计目标是:

标准化模型调用过程中的上下文传递结构;

明确用户意图、工具接口和历史状态;

降低开发者在多组件集成时的心智负担。

MCP 的结构组成示例代码(伪代码,适用于 JSON 结构):

{

"context": {

"user_id": "abc123",

"goals": ["回答简洁", "使用 Markdown 格式"],

"tools": [

{ "name": "web-search", "enabled": true },

{ "name": "math-engine", "enabled": false }

],

"memory": [

{ "role": "user", "content": "什么是量子计算?" },

{ "role": "assistant", "content": "量子计算是一种..." }

]

},

"input": "请再举个实际应用例子。",

"metadata": {

"session_id": "s-889900",

"timestamp": "2025-06-06T08:00:00Z"

}

}此处的 "context" 字段即为 MCP 结构的核心,它将用户意图与历史记录合并管理,使模型更好“理解”输入内容。

常见错误提醒:

❌ 误将上下文结构嵌套太深:会导致模型解析困难,建议保持结构扁平清晰。

❌ 遗漏历史记录字段:若省略

"history",模型将无法建立语境连接。

步骤二:如何在客户端正确初始化 MCP 上下文

在客户端创建请求前,应初始化并缓存 MCP 上下文,这样可以在用户操作中持续更新上下文,而不是每次都重新构建。

应用场景举例:

假设你正在构建一个 AI 写作助手,用户可以持续发起请求,要求模型记住文风、主题、关键词等。此时就需要:

初始化一个 MCP 上下文对象;

持续更新 memory;

支持 goals 和工具动态修改。

示例(以 JavaScript + fetch API 为例):

const MCP = reactive({

user_id: "writer001",

goals: ["写作风格偏文学", "输出 markdown 格式"],

tools: [{ name: "grammar-check", enabled: true }],

memory: []

});

function sendToLLM(userInput) {

MCP.memory.push({ role: "user", content: userInput });

fetch("/api/chat", {

method: "POST",

headers: { "Content-Type": "application/json" },

body: JSON.stringify({

context: MCP,

input: userInput

})

})

.then(res => res.json())

.then(res => {

MCP.memory.push({ role: "assistant", content: res.reply });

});

}常见错误提醒:

❌ 每次请求都重置

mcpContext:这会导致“失忆”,历史语境全部丢失。❌ 未考虑并发更新问题:如果多个请求同时修改

history,可能造成上下文错乱。

关键提醒:

记得清理 memory:通过只保留最近 5~10 轮来防止 payload 过大;

tools 状态可根据场景实时切换;

建议将 MCP 对象持久化(如 localStorage)防止刷新丢失。

步骤三:在服务端动态更新上下文

模型在响应后,服务端可以根据逻辑自动调整 MCP,例如根据分析结果动态增加用户偏好标签。

服务端不仅是转发者,还是“智能补全器”,可以:

根据模型响应动态增强 goals;

记录用户偏好进数据库;

控制 memory 长度、格式和重要性。

示例(以 Node.js 表示服务端更新逻辑):

function processMCPContext(mcp, response) {

if (response.includes("写作建议")) {

if (!mcp.goals.includes("提供写作技巧")) {

mcp.goals.push("提供写作技巧");

}

}

// 历史对话裁剪

if (mcp.memory.length > 10) {

mcp.memory = mcp.memory.slice(-10);

}

return mcp;

}结合前端发送的上下文,服务端能持续调整模型行为,实现更加个性化的交互体验。

常见错误提醒:

❌ 滥用标签自动推断逻辑:可能导致模型行为越来越不可控,建议设置最大标签数量。

❌ 未对历史长度做裁剪:历史记录不断增长会拖慢响应速度,建议保留最近若干轮对话。

彩蛋:性能优化与工具推荐

🎯 性能优化技巧:

历史裁剪算法:仅保留最近 N 轮对话(如 5 轮),以减少请求体积。

上下文压缩策略:对旧记录做摘要,如

"user asked about API"替代原始长内容。上下文权重控制:为某些语句设置“重要性”字段,模型可据此优先考虑关键信息。

🧰 工具推荐列表:

| 工具 | 用途 |

|---|---|

| LangChain | 管理多轮对话上下文的利器 |

| Semantic Kernel | 微软出品的上下文感知框架 |

| GPT Index / LlamaIndex | 将结构化数据映射为上下文索引 |

| Zustand | React 中用于管理对话状态的小巧状态管理库 |

| JSON Schema Validator | 校验你的 MCP JSON 结构是否符合规范 |

结语

通过 MCP,你可以让模型更智能、更“有记忆”。从设计结构、初始化上下文到动态更新,MCP 是构建复杂交互系统的关键桥梁。赶快在你的下一个 AI 项目中用上它吧!

微信扫一扫,打赏作者吧~

微信扫一扫,打赏作者吧~版权声明

如有错误或侵权,请联系我修改或删除,QQ374060。

哈溜

哈溜

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。