🚀零基础上手!轻量级微调(LoRA微调)实操教程

原创

不用超级算力,也能让AI听懂你的业务!

✨ 什么是轻量级微调?

简单来说,轻量级微调就像是“给AI打小补丁”,而不是重装整个系统。

如果把一个预训练大模型(如ChatGPT、通义千问、Kimi)比作一台豪华汽车,

轻量微调就是

🚗 不动引擎,只换一个特制轮胎,让它跑你想跑的路。

🎯 为什么要做轻量级微调?

✅ 普通用户也能搞:普通消费级电脑即可。

✅ 速度快:几个小时甚至几十分钟搞定。

✅ 成本低:极大节省算力资源。

✅ 效果好:特定领域提升明显!

🌍 支持轻量微调的热门模型

| 模型 | 公司 | 特点 |

|---|---|---|

| ChatGPT(OpenAI) | 美国 | 支持自定义GPT,轻量定制 |

| 通义千问(阿里巴巴) | 中国 | 开放企业微调接口 |

| 月之暗面Kimi(Moonshot AI) | 中国 | 文档类处理很强 |

| 百川大模型(Baichuan) | 中国 | 开源可本地部署 |

| 深言(MiniMax) | 中国 | 面向对话式场景的微调 |

🛠️ 轻量微调实操流程

① 准备微调数据 📚

数据是给AI补课的教材。

常见数据格式:

问答对(Q&A)

对话日志

文档摘要

举个例子:

如果你想训练一个懂咖啡的AI,可以准备数据集:

Q:拿铁和卡布奇诺的区别?

A:拿铁奶更多,卡布奇诺奶泡更厚。

② 选择模型和工具 🛒

想用ChatGPT?

👉 用自定义GPT功能,无代码!想本地训练?

👉 选择Baichuan-7B、Qwen-7B等开源模型,搭配LoRA微调。企业需求?

👉 接入通义千问、MiniMax官方微调接口。

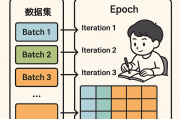

③ 开始轻量级微调 ⚡

本地轻量微调示例(代码版):

bash复制编辑pip install transformers peft bitsandbytes

python复制编辑from peft import get_peft_model, LoraConfig config = LoraConfig( r=8, lora_alpha=32, target_modules=["q_proj", "v_proj"], lora_dropout=0.05, bias="none", task_type="CAUSAL_LM") model = get_peft_model(model, config)

然后开始训练,通常几个小时即可完成!

④ 验证效果 ✅

测试一下:

新问题回答是否更准确?

有没有出现奇怪的偏差?

每次微调后都要认真验证哦!

🧠 小Tips

💡 数据越干净,微调效果越好!

💡 一次微调不要改太多,防止模型遗忘原来学过的内容!

💡 轻量微调适合专精一个领域,比如:法律、医疗、教育、金融等。

🔥 推荐微调场景

👩💼 企业客服专属机器人

📚 专业领域答题助手

📈 企业内部知识库AI

🛒 个性化电商推荐系统

✨ 总结

掌握了轻量级微调,

就像拥有了一个能为你量身定制的专属AI助手!

未来,谁能灵活运用微调技术,谁就能把AI真正用好!🚀

微信扫一扫,打赏作者吧~

微信扫一扫,打赏作者吧~版权声明

如有错误或侵权,请联系我修改或删除,QQ374060。

哈溜

哈溜

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。