MCP Server 是什么?

原创MCP Server 是一套服务端中间层,用于集中管理和处理与语言模型交互所需的上下文(context)、记忆(memory)、插件工具(tools)等信息。它充当模型调用的**“上下文大脑 + 调度中心”**,通常位于前端与 LLM API 之间。

它的核心职责包括:

维护用户上下文结构(符合 MCP 协议)

自动更新、裁剪、摘要历史 memory

控制工具链状态、参数注入

调用 LLM 并封装输出,供前端/应用层使用

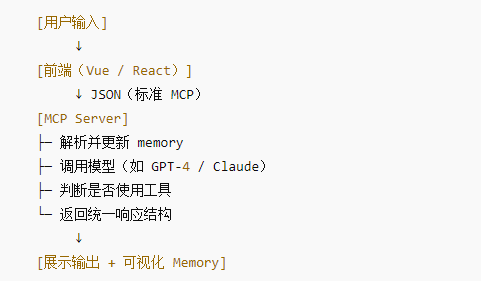

🧱 MCP Server 架构简图

🔧 使用 MCP Server:搭建与请求流程

1️⃣ 启动服务(假设用 Node.js + Express)

git clone https://github.com/your-org/mcp-servercd mcp-server npm install node index.js

默认监听端口:http://localhost:4000

2️⃣ 请求示例

前端(或 Postman)向 /chat 接口 POST:

{

"context": {

"user_id": "user123",

"goals": ["使用 Markdown", "回答简洁"],

"tools": [{ "name": "web-search", "enabled": true }],

"memory": [

{ "role": "user", "content": "介绍一下ChatGPT" }

]

},

"input": "那它能帮我写日报吗?"

}服务端处理步骤:

检查 context 完整性;

裁剪历史 memory;

判断是否调用工具;

调用 LLM API;

更新 memory;

返回结果:

{

"reply": "当然,ChatGPT 可以协助撰写日报内容...",

"updated_context": { ... } // memory 已自动追加

}🧠 常见功能扩展

| 功能 | 描述 |

|---|---|

| ✂ 自动 memory 剪枝 | 限制最多 10 轮,旧内容可摘要 |

| 🧠 持久化上下文 | 将每个用户的上下文存入 Redis / MongoDB |

| 🔧 工具链调度 | 若 tools.web-search.enabled=true,则先调用搜索 API 插入 context |

| 📊 监控与日志 | 打印调用时长、token 用量,便于优化费用和性能 |

| 🔐 权限控制 | 检查 metadata.user_level,决定是否允许调用某些工具 |

🧰 可选部署策略

| 场景 | 技术选型 |

|---|---|

| 单体应用(开发测试) | Node.js + Express |

| 企业部署 | Flask / FastAPI + Redis + PostgreSQL |

| 高并发 SaaS | Kubernetes + Redis + Vector Store(如 Pinecone)+ Nginx API Gateway |

| 与前端无缝集成 | GraphQL API + WebSocket 推送 memory 状态变化 |

🧪 MCP Server 调试建议

加日志:打印每轮 memory 长度与 token 数

开发者模式:开启 “verbose” 模式打印 goals / tools / metadata

接口文档:使用 Swagger 自动生成接口说明

模拟用户:预设测试脚本不断发起请求,测试上下文积累逻辑

✅ 总结:为什么要用 MCP Server?

| 问题 | 传统调用方式 | MCP Server 优势 |

|---|---|---|

| 上下文维护复杂 | 拼接字符串,代码混乱 | 统一结构,自动更新 |

| 无法灵活调工具 | 手动触发,每次重写逻辑 | 配置式 tools,按需调度 |

| 没有 memory 清理 | 长对话易超限 | 自动裁剪或摘要 |

| 不具备多用户支持 | 零 session 概念 | 每个用户一个 MCP 上下文 |

目前有几种免费或带有免费额度的接口服务可以用于搭建和测试你的 MCP Server,适合开发初期验证功能和原型。以下是几种常见选择:

✅ 推荐免费接口适配 MCP Server

1. OpenAI GPT-3.5 Turbo API(有免费额度)

免费额度:注册新账号赠送 $5-$18(具体以地区和时间为准)

API 兼容:

/v1/chat/completions用途:标准对话、上下文注入、MCP memory 流水线

2. Google Gemini Pro(免费调用)

免费调用:Google Cloud 注册后可调用 Gemini Pro 模型

优点:适合多模态扩展,支持图文输入

限制:需要配置 Google Cloud 项目

3. Claude 3(通过 Poe 平台免费调用)

方法一:通过 https://poe.com 免费使用 Claude 模型(限速)

方法二:申请 Anthropic 官方 API,企业申请有免费试用额度

API 文档:https://docs.anthropic.com/

4. OpenRouter.ai(聚合多模型,支持免费测试)

模型聚合平台,支持 GPT、Claude、Mistral、Gemini 等

提供一定免费调用额度

接口兼容 OpenAI 风格,方便接入 MCP

5. 免费本地部署模型:

适合离线场景测试 MCP Server 结构,虽然能力有限,但可用于原型开发。

| 模型 | 工具平台 | 说明 |

|---|---|---|

| Mistral / LLaMA2 | Ollama | 本地部署,API 类似 OpenAI |

| ChatGLM3 | ModelScope / Transformers | 支持中文交互,可适配内网 MCP Server |

| Deepseek | HuggingFace | 适合代码任务测试 MCP 工具链 |

💡 实践建议

调试阶段推荐使用 OpenRouter.ai 或 Ollama;

接入生产级功能再切换到 GPT-4、Claude 等高精度模型;

如有经费限制,本地推理(如 Mistral)+ RAG 方案是 MCP 非常好的训练场。

微信扫一扫,打赏作者吧~

微信扫一扫,打赏作者吧~版权声明

如有错误或侵权,请联系我修改或删除,QQ374060。

哈溜

哈溜

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。