人工智能可以根据文本描述快速创造出图像。它的工作远原理是什么?

原创一、基本原理:扩散与去噪的逆向过程

前向扩散:系统通过向原始图像逐步添加高斯噪声,最终将图像完全转化为随机噪声。这类似于将一幅画不断泼墨直到完全模糊的过程。

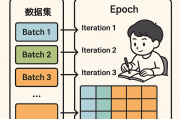

反向扩散(去噪) :模型通过深度学习掌握噪声与图像特征的对应关系,能够从纯噪声开始,通过多轮迭代逐步预测并去除噪声,最终恢复出符合文本描述的清晰图像。

二、关键技术组件

文本编码系统(如CLIP)

通过对比学习海量图文数据,将文本描述转化为高维向量(如CLIP模型的文本嵌入),精准捕捉"金属质感""未来风格"等抽象概念。例如输入"戴眼镜的少女",模型会提取眼镜、年轻女性等关键标记。潜在空间压缩(VAE)

使用变分自编码器将图像压缩到低维潜在空间(如64x64像素),相比直接在像素空间操作,计算效率提升约30倍

。这种"缩小画布"的操作让生成过程更高效。U-Net调度算法

作为去噪核心组件,通过残差连接结构在保留图像整体结构的同时细化细节。每次迭代都会调整噪声预测,最终输出512x512高清图像。

三、控制图像生成的核心手段

| 控制维度 | 实现方式 | 示例效果 |

|---|---|---|

| 提示词(Prompt) | 正向描述所需元素(如"赛博朋克风格"),负面提示词排除元素(如"模糊") | 精确控制场景构成 |

| 模型微调 | 通过LoRA等轻量化训练技术注入特定风格(如水墨画/3D渲染) | 生成迪士尼/吉卜力风格图像 |

| ControlNet | 通过线稿、深度图等辅助控制构图,解决AI绘画的随机性问题 | 精确复刻人物姿势或建筑结构 |

四、与其他模型的差异化特征

与DALL-E相比,Stable Diffusion具有以下特点:

开源优势:允许本地部署和模型定制,保护隐私的同时支持个性化创作

跨模态扩展:除文生图外,支持图生图、图像修复等任务

计算效率:在消费级GPU上即可运行,生成速度比早期模型快5-10倍

五、应用与局限

突破性应用包括:

科研领域:生成蛋白质3D模型辅助药物研发

艺术创作:Midjourney生成游戏概念艺术,单幅作品创作时间从周级缩短至分钟级

工业设计:快速迭代产品外观原型

现存局限性:

物理规律违背:可能生成违反透视原理的错位结构

版权争议:训练数据包含未授权作品引发的法律风险

语义理解偏差:对复杂长文本的解析准确率约68%(FID评估指标)

通过这种"噪声雕刻"式的生成机制,AI实现了从语言到视觉的跨维度转换。正如所述:"这不仅是技术突破,更是人类认知边界的拓展"。随着ControlNet等控制技术的发展,AI绘画正从随机生成走向精准可控的创作新时代。

微信扫一扫,打赏作者吧~

微信扫一扫,打赏作者吧~版权声明

如有错误或侵权,请联系我修改或删除,QQ374060。

哈溜

哈溜

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。